DeepSeek+RAGFlow构建本地知识库

引言

在 AI 领域,RAG(Retrieval-Augmented Generation,检索增强生成)技术被广泛用于增强大语言模型(LLM)的知识能力。本文将介绍如何使用 DeepSeek 与 RAGFlow 搭建本地知识库,实现高效的知识检索与增强。

本教程基于以下设备进行测试:

1 | 处理器:13th Gen Intel(R) Core(TM) i5-13400F 2.50 GHz |

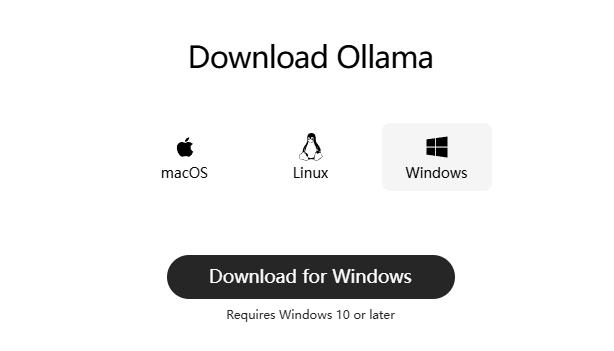

一:下载Ollama

Ollama 是一个开源的大型语言模型(LLM)平台,旨在让用户能够轻松地在本地运行、管理和与大型语言模型进行交互。

Ollama的Github仓库里面也更加详细的介绍,接下来点击这个链接下载(https://ollama.com/download)应用程序

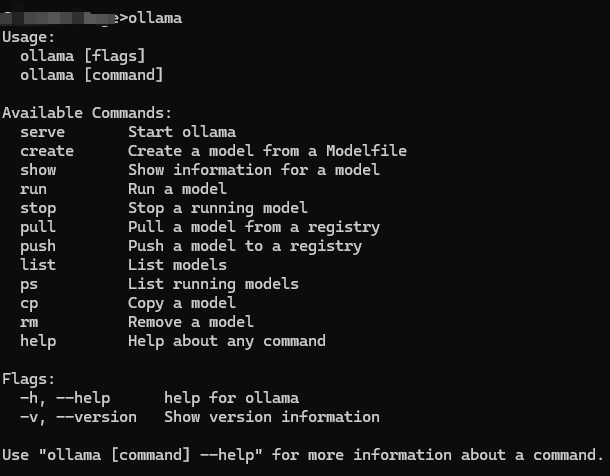

安装完成后,按下 Win+R,输入 cmd 打开终端,并输入以下命令检查安装状态:

1 | ollama |

如果出现如下输出,说明安装成功。

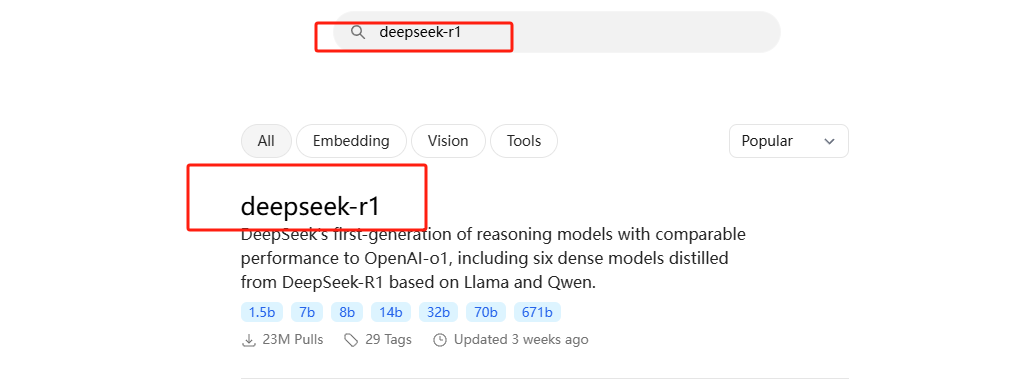

二:部署DeepSeek模型

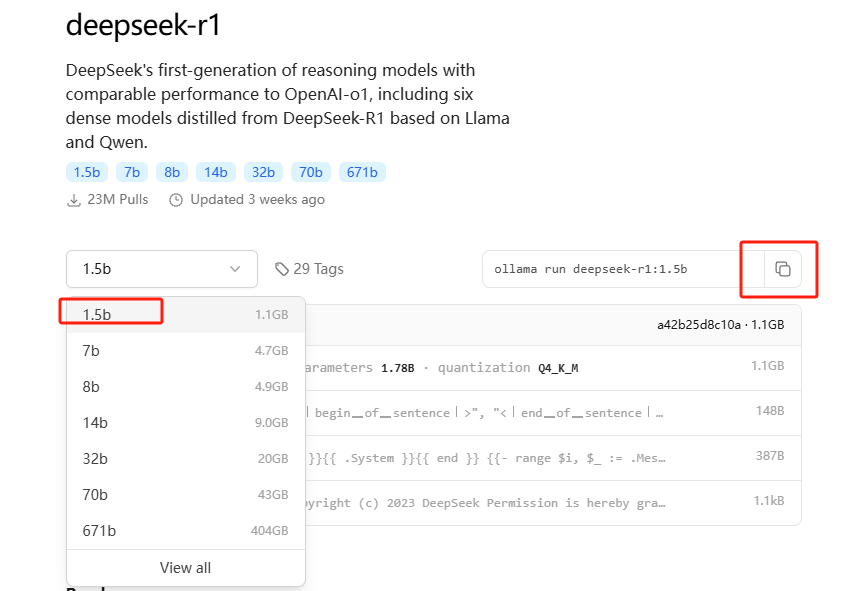

在ollama官网最上方的搜索框中输入 deepseek-r1,进入这个模型

找到适合自己的模型并复制命令

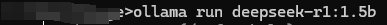

复制命令并在终端执行(以下以 1.5B 模型为例):

1 | ollama pull deepseek-r1:1.5b |

运行以下命令检查是否安装成功:

1 | ollama list |

显示 deepseek-r1:1.5b,说明已经安装成功。

模型硬件要求

| 版本 | CPU | 内存 | 显卡 | 存储 |

|---|---|---|---|---|

| DeepSeek-R1-1.5B | 任意四核处理器 | 8GB | 无需 GPU | 12GB |

| DeepSeek-R1-7B | Ryzen 7 或更高 | 16GB | RTX 3060 (12GB) 或更高 | 80GB |

| DeepSeek-R1-14B | i9-13900K 或更高 | 32GB | RTX 4090 (24GB) 或更高 | 200GB |

| DeepSeek-R1-32B | Xeon 8核+128GB 或更高 | 64GB | 2-4张 A100 80GB 或更高 | 320GB |

| DeepSeek-R1-70B | Xeon 8核+128GB 或更高 | 128GB | 8+张 A100/H100,显存 ≥80GB/卡 | 500GB+ |

三:安装Docker Desktop

下载地址:https://www.docker.com/,下载好后安装即可

- 安装完成后,打开 Docker Desktop。

- 如果出现

Docker Engine stopped错误,可能是缺少 WSL 支持。 - 运行以下命令安装 WSL:

1

wsl --update

- 重新启动 Docker Desktop。

四:安装RAGFlow

设备要求如下:

1 | CPU >= 4 核 |

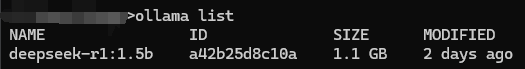

RAGFlow的Github仓库地址:https://github.com/infiniflow/ragflow,下载即可,地址里面对RAGFlow的介绍很详细,可以阅读一遍

下载压缩包后并解压,找到 ragflow-main/docker/.env文件

- 找到

RAGFLOW_IMAGE=infiniflow/ragflow:v0.17.0-slim并添加注释“#” - 找到

RAGFLOW_IMAGE=infiniflow/ragflow:v0.17.0并删除注释“#”

在 docker 目录下打开 CMD,执行以下命令:

1 | docker compose -f docker-compose.yml up -d |

出现以下图案则说明服务器启动成功:

1 | ____ ___ ______ ______ __ |

五:配置环境变量

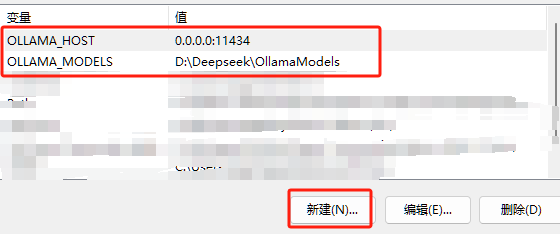

进入电脑设置>系统>高级系统设置>环境变量,在用户变量里新建如下两个变量

OLLAMA_MODELS值的地址为存放ollama下载的模型

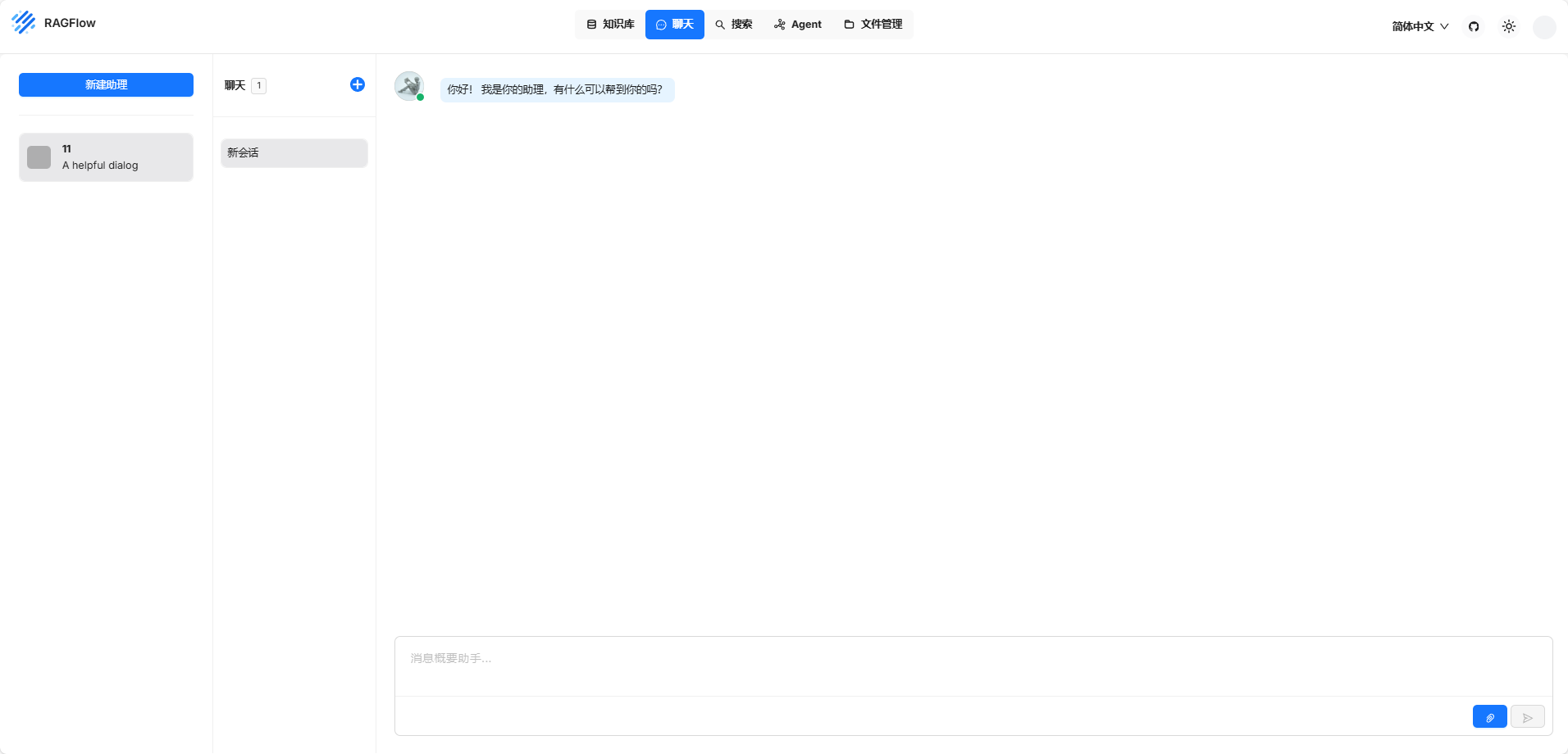

六:配置RAGFlow知识库

在浏览器输入 localhost:80,进入登录页面,首次注册默认是管理员账号。

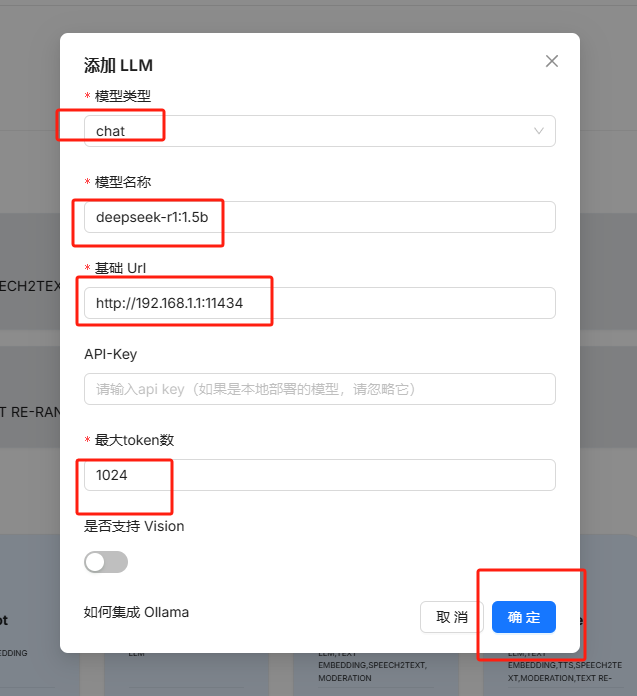

点击右上角头像>模型提供商>Ollama,然后输入配置信息

模型类型选 chat,模型名称填入刚刚下载的deepseek大模型 deepseek-r1:1.5b,url填写 http://ip地址:11434

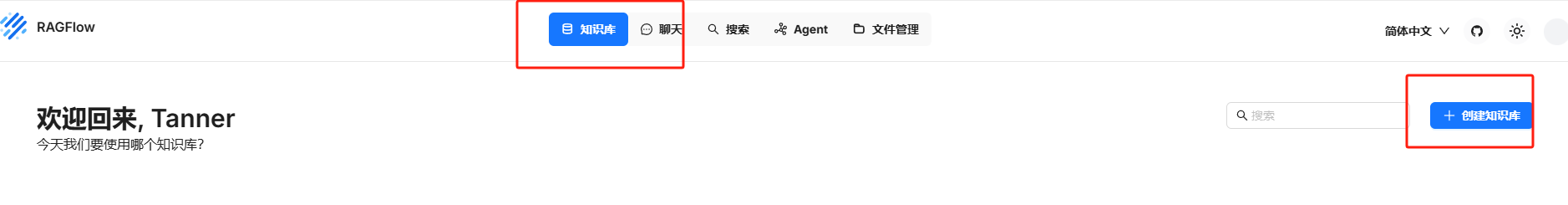

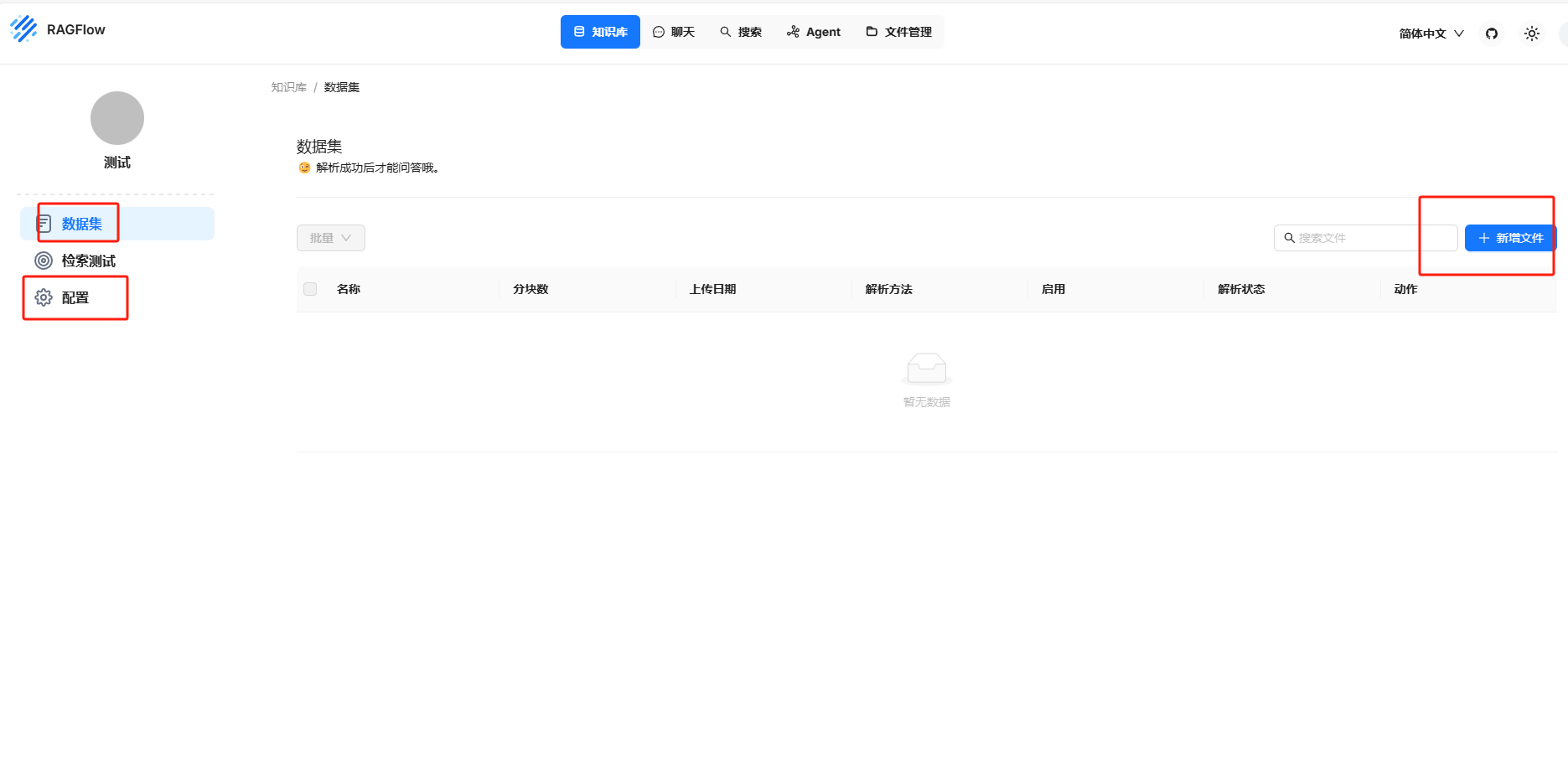

进入知识库页面,创建一个新的知识库。

配置可以根据需求选择,然后上传自己的数据集

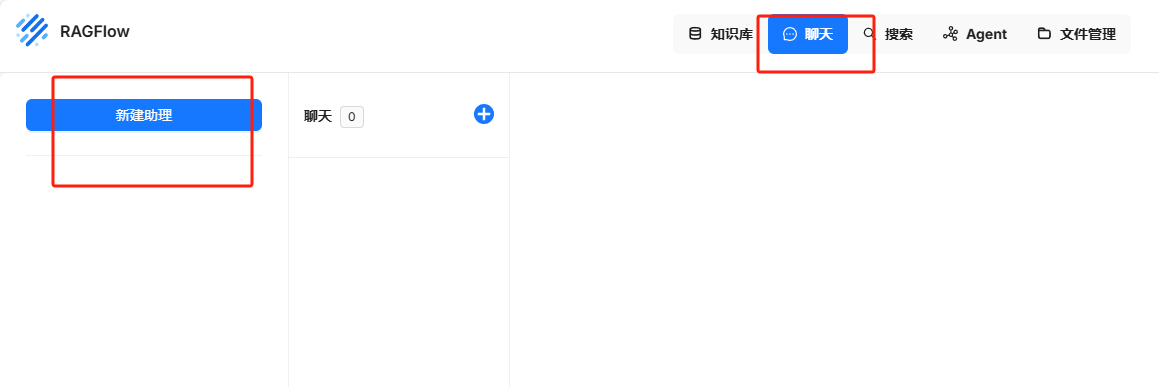

进入 聊天 > 新建助理。

知识库选项必须选择刚刚创建的知识库,其他可以必填项按照提示填写即可

至此,你的本地知识库已经成功搭建,可以开始使用啦!🎉